今年来,随着算力的不断增加和深度学习等技术的进步,AI在内容生产领域的应用已经不仅仅局限于图片和文字。最近,内容生成AI可以说正式进入视频时代,未来用描述性的文字直接生成脑海中的画面将不再困难,人人都将能够制作出电影级别的长短视频。

当看到下面这个“马儿低头喝水”的画面时,相信每个人都会认为这是对一段事先拍摄好的视频加上了动漫化的滤镜,但真实的情况却是,这个视频里的每一个像素全都是由AI来生成的,仅仅是对AI模型输入了一句简单“马儿喝水”。

据了解,该AI模型名为“Make-A-Video”,是由Meta AI的研究人员开发出来的,任意给模型输入几个单词或几行文字,就能生成符合语义的但在现实中却并不存在的视频画面,而且风格还可以多元化。

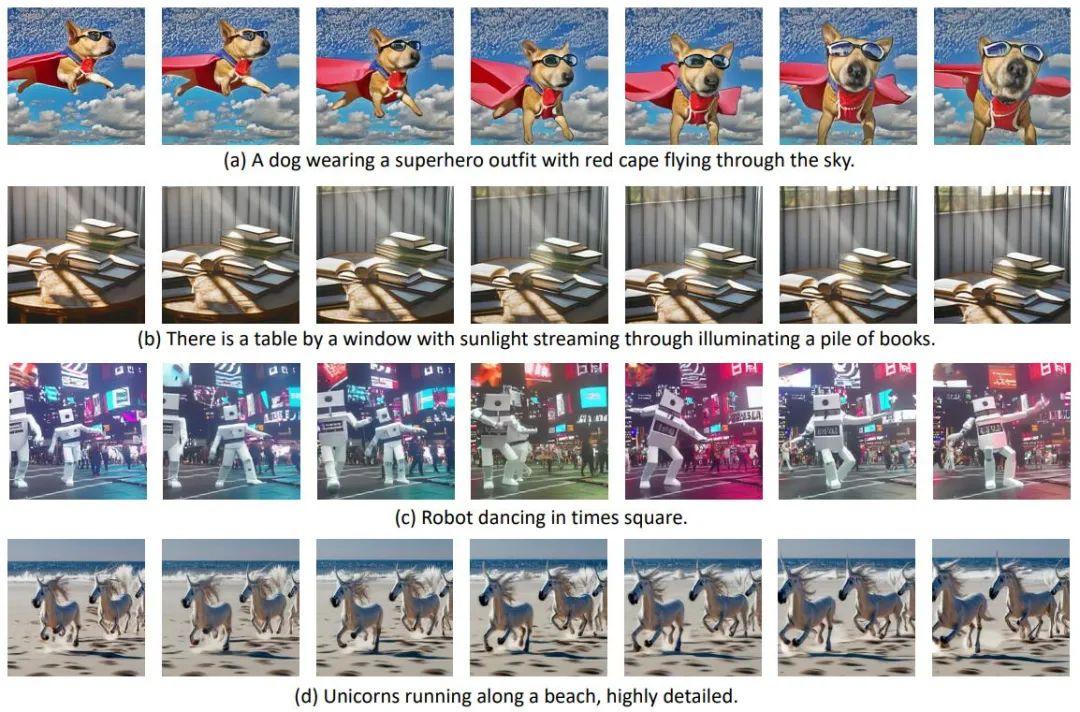

例如,将一些英文短句输入模型之后,生成的视频也都让人叹为观止:

不得不说,现在人工智能的发展真的是日新月异,每隔一段时间就会给人不同的惊喜。

从图像到视频,生成模型功不可没

最近几年,人工智能在视觉领域的发展可谓是“神速”。去年1月,致力于“用通用人工智能造福全人类”的OpenAI公司基于GPT-3模型发布了划时代的 DALL·E,实现了从文本生成图像。

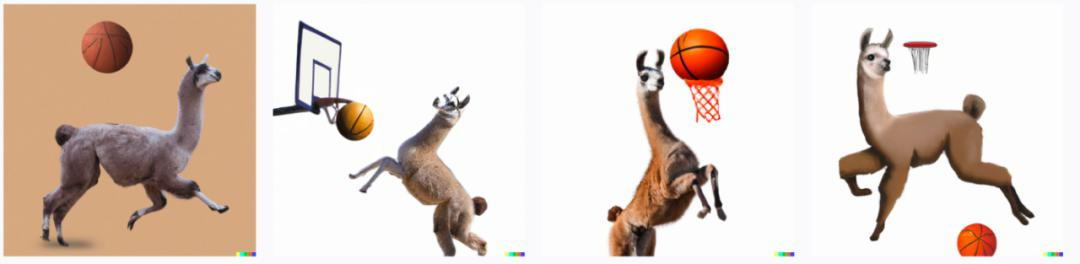

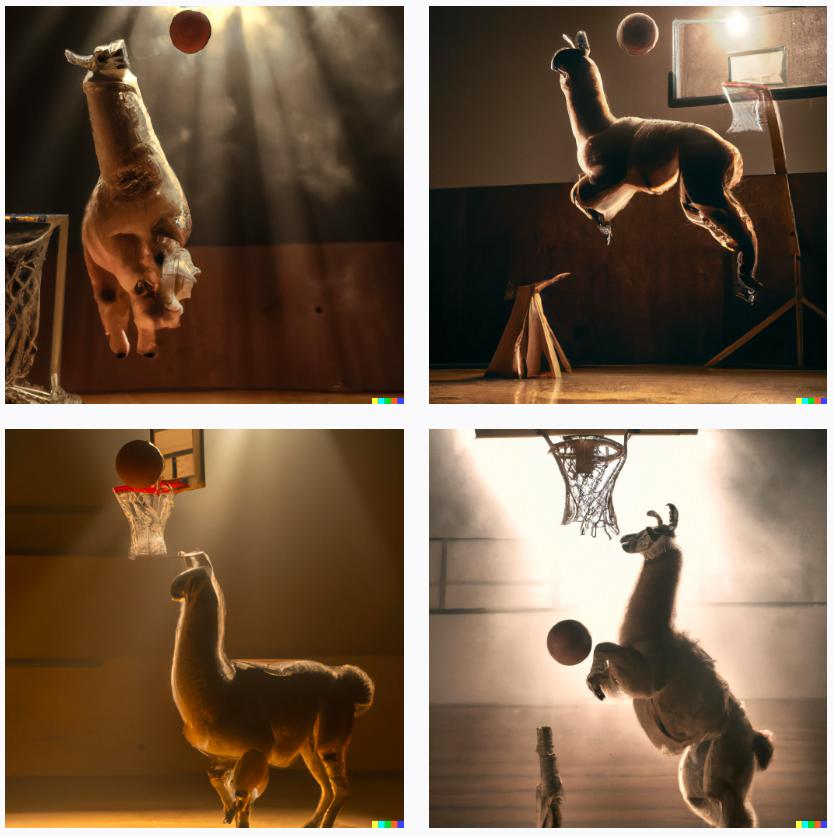

今年4月份,OpenAI发布的第二代DALL·E 2模型,再次为图像生成领域树立了全新标杆,可以通过简短的文本描述(prompt)来生成相应的图像,使得不会画画的人也可以将自己的想象力变为艺术创作,例如“羊驼打篮球”这句话生成的四张图片看起来就非常符合大家预期的想象。

不仅如此,随着文字描述的颗粒度不断细化,生成的图像也会越来越精准,效果在非专业人士看来已经相当震撼。

但DALL-E 2这样的模型仍然停留在二维创作即图片生成领域,无法生成360度无死角的3D模型。但这依旧难不住极具创意的算法研究员,Google Research的一项最新成果——DreamFusion模型,即可通过输入简单的文本提示生成3D模型,不仅能够在不同的光照条件下进行渲染,而且生成的3D模型还具有密度、颜色等特性,甚至可以把生成的多个3D模型融合到一个场景里。

在生成3D图片之后,Meta的算法人员将思路进一步打开,向更高难度发起挑战,开始探索用文字提示来直接生成视频。

虽然本质上来说,视频就是一系列图像的叠加,但相比于生成图像,用文字来生成视频时不仅需要生成相同场景下的多个帧,还要保证相邻帧之间的连贯性,训练模型时可用的高质量视频数据非常少,但计算量却很大,大大增加了视频生成任务的复杂性。

9月29日,来自Meta的研究人员发布了Make-A-Video,这是一个基于人工智能的高质量短视频生成模型,相当于视频版的DALL·E,也被戏称为“用嘴做视频”,即可以通过文本提示创建新的视频内容,其背后使用的关键技术也同样来自DALL-E等图像生成器所使用的文本-图像合成技术。

仅1周之后,谷歌CEO皮查伊就接连官宣了两个模型来正面挑战Meta的Make-A-Video,分别是Imagen Video与Phenaki。

与Make-A-Video相比,Imagen Video更加突出视频的高清特性,能生成1280*768分辨率、每秒24帧的视频片段,还能理解并生成不同艺术风格的作品;理解物体的3D结构,在旋转展示中不会变形;甚至还继承了Imagen准确描绘文字的能力,在此基础上仅靠简单描述产生各种创意动画。

而Phenaki则能根据200个词左右的提示语生成2分钟以上的较低分辨率长镜头,讲述一个相对完整的故事。

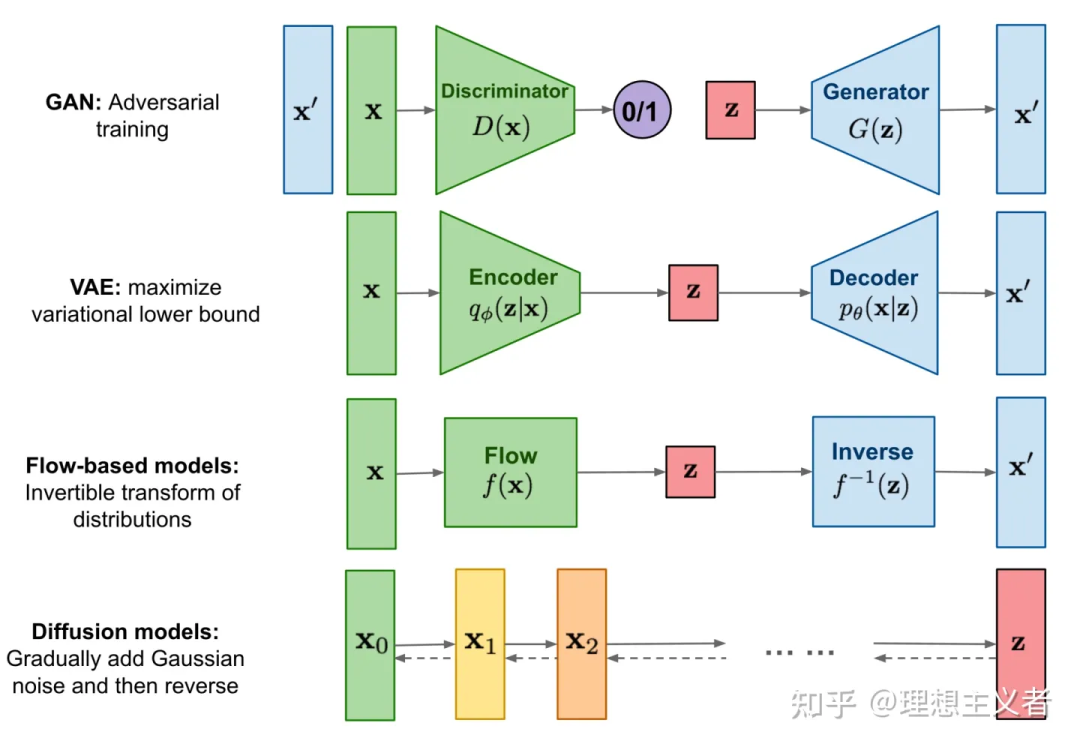

在计算机视觉领域中,文本生成图像或视频用到最多的就是生成模型,生成模型也在最近的文本到图像 AI 系统中取得了重大进展,比如 DALL-E 2、Imagen、Parti、CogView 和 Latent Diffusion等。这些新模型和算法的基本思路都来自于早期最出名的GAN(生成对抗网络),即通过生成器和辨别器之间的相互对抗来生成图像。但由于模型本身具有对抗性,因此很难进行训练,而利用扩散模型则可以解决这个问题,这也是今年最火的模型之一。

扩散模型也是生成模型的一种,其背后的直觉和原理来源于物理学:气体分子从高密度区域扩散到低密度区域的现象与由于噪声干扰而导致信息丢失的现象相似。所以通过引入噪声导致信息的衰减,再尝试通过去噪来生成图像,就能通过多次迭代,使得模型每次都在给定一些噪声输入的情况下学习生成新图像。如今,扩散模型在密度估计、文本到语音、图像到图像、文本到图像和 3D 合成等多种生成式建模任务中都取得了巨大成功。

短视频创作者可暂时“松一口气”

自人工智能得以真正发展以来,每当有了令人惊叹的新进展后都会有相同的一个问题出现,即AI到底会不会取代人类,由扩散模型带火的文字生成视频也不例外。

对于这个问题,Stability AI的新任首席信息官Daniel Jeffries曾经表示,AI最终会带来更多的工作岗位,就像相机的发明虽然取代了大部分画家,但也创造了摄影师这一职业,同时还开辟了电影、电视这样更大规模的全新产业。

虽然对于普通用户等非专业人士来说,当前AI生成的视频效果已经足够惊艳,但相信真正的业内人士能够一眼看出AI还是缺乏对每一个镜头的精细控制,也没有任何真正的思考注入到视频的内容当中,对于AI取代视频创作者的担忧恐怕为时过早。

不过,这些AI技术对于工作的辅助作用有立竿见影的效果。如对于媒体行业来说,常常有“一图胜千言”的情况发生,很多时候写好了的文字,总差一张恰到好处的配图来画龙点睛。

此外,如果不能恰当地引用图片并标注来源,还会造成一定的法律风险,当有了AI辅助生成图片或视频内容之后,虽然可以规避类似问题,但新的问题也接踵而来。

AI总在钻各种法律的空子

2019年时,一款名为“ZAO”的AI换脸软件曾经火爆全网,用户只需要在APP中上传一张照片,就能将自己的脸替换成任何想要替换的人,并且人脸融合效果非常好,达到了以假乱真的程度。不过,尽管该软件很有趣,并且将技术门槛降到最低,但很快也遭到了用户的抵制,因为该软件获取的个人信息并无法保障其安全性,这很有可能让不法分子钻了空子。

同样,在AI生成视频领域,这样的恶意创作依旧不可避免,出于安全和伦理的考虑,谷歌表示暂时不会发布两个视频生成模型的代码或Demo。Meta也承认,按需制作真实感视频的能力存在一定的社会危害,因此将所有由AI生成的视频内容都加上了水印,以“确保观众知道这段视频是由人工智能生成的,而不是捕捉到的视频。”

通常情况下,传统理论认为,作为智力活动的创作只能由人类的思维活动来实现,即作品是自然人思想观念的表达。但在人工智能时代,这一理论将会受到重大挑战,人们也需要重新思考与之相关的新标准、新道德、新法规。

参考资料:

1.《真·拿嘴做视频!Meta「AI导演」一句话搞定视频素材,网友:我已跟不上AI发展速度》,量子位

2.《谷歌AI生成视频两连发:720p高清+长镜头,网友:对短视频行业冲击太大》,量子位

3.《图像生成卷腻了,谷歌全面转向文字→视频生成,两大利器同时挑战分辨率和长度》,机器之心