计算机视觉是一个在过去几十年中被研究得相当多的领域,主要是因为它在建造自动驾驶汽车和其他可以像人类一样"看"世界的工具方面有着直接和明显的应用。然而,直到最近才看到这种水平的研究的一个领域是使用声音而不是视觉来模拟环境。现在,麻省理工学院(MIT)的研究人员已经撰写了一篇研究论文,涉及在这一领域训练的机器学习(ML)模型的构建。

麻省理工学院新闻网站上的一篇博文介绍说,MIT-IBM沃森人工智能实验室合作建立了一个ML模型,利用空间声学来观察和模拟环境。简单地说,这个模型通过弄清听众如何听到从某一点发出的声音并传播到不同的位置,实现了环境的映射。

这种技术有许多好处,因为它可以只用声音来确定环境物体的基本三维几何形状。然后,它可以呈现准确的视觉效果来重建环境。潜在的应用包括虚拟和增强现实,以及增强人工智能代理,使其能够利用声音和视觉来更好地可视化其环境。例如,与计算机视觉相比,水下探索机器人可以利用声学来更好地确定某些物体的位置。

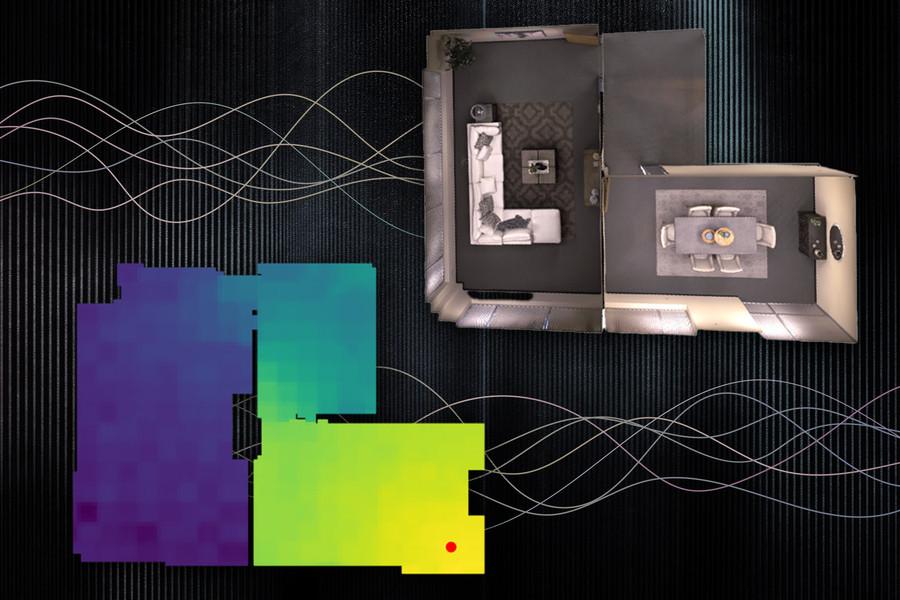

图形显示的是房间的3D模型,下面是带有声音的热视图类型的概念

研究人员强调,建立这种基于声音的ML模型要比基于计算机视觉的模型复杂得多。这是因为计算机视觉模型利用了一种叫做光度一致性的属性,这意味着一个物体从不同角度看时看起来大致相同。这不适用于声音,因为根据聆听方的位置和其他障碍物,从一个源头听到的东西可能非常不一样。

为了解决这个问题,研究人员使用了另外两个特征,即互易性和局部几何学。前者基本上意味着,即使交换了说话者和听众的位置,声音也会完全相同。同时,局部几何映射涉及在神经声场(NAF)中结合互易性来捕捉物体和其他建筑组件。

为了让ML模型在测试环境中工作,需要向它输入一些视觉信息和光谱图,其中包含基于发端者和听众的指定位置的音频听起来会是什么样子。根据这些输入,该模型可以准确地确定当听众在环境中移动时,声音将如何变化。

该研究论文的主要作者Andrew Luo指出:“如果你想象自己站在一个门口附近,对你听到的声音影响最强烈的是那个门口的存在,而不一定是房间另一边离你很远的几何特征,我们发现这些信息比简单的全连接网络能更好地概括。”

展望未来,研究人员希望进一步加强该模型,使其能够将更大、更复杂的环境可视化,如一栋建筑甚至整个城市。